«ИИ не может быть оправданием»: что происходит, когда чат-бот Meta заклеймит профессора колледжа как террориста?

Будущие технологии и их применение

У Мариетье Шааке долгая и выдающаяся карьера. Она была советником посла США в Нидерландах и консультировала министерство иностранных дел Нидерландов.

В течение 10 лет она была членом Европейского парламента, разрабатывая законы, которые касались сотен миллионов людей. , уделяя особое внимание цифровым свободам. Теперь она директор по международной политике в Центре киберполитики Стэнфордского университета.

К длинному списку достижений в ее резюме теперь можно добавить еще одну запись: террорист.

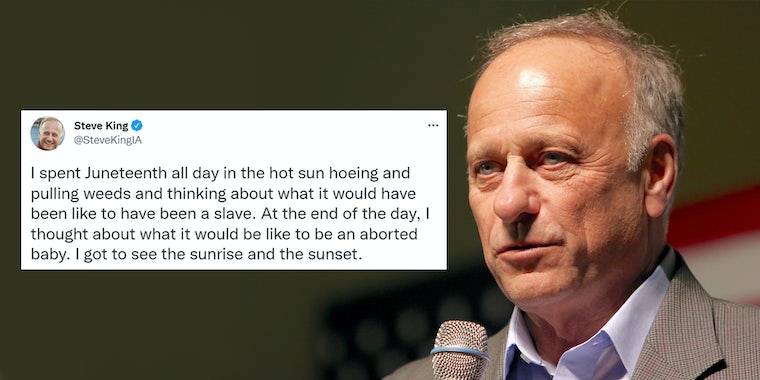

Это ответ Меты. спорный чат-бот BlenderBot 3, который уже подвергся тщательной проверке, среди прочего, за то, что он делал неожиданные антисемитские комментарии пользователям.

Необоснованное обвинение BlenderBot в том, что Шааке якобы является террористкой, было раскрыто ее коллегой из Стэнфорда Джен Кинг в разговор, позже опубликованный в Твиттере.

Когда Кинг рассказала Шааке об этой новости, она сказала в интервью Daily Dot: «Я не могла в это поверить. Я сразу же увидел скриншот и подумал: «Я думал, что видел все это… не думаю». Я был удивлен крайним несоответствием, но, увидев ранее очень плохо запрограммированные и работающие чат-боты, это подтвердило мой скептицизм в отношении этих инструментов».

Бывший политик, а ныне кибер-профессор сказал, что Meta никогда не должна была запускать BlenderBot. на мир, учитывая многочисленные проблемы с ним, которые были обнаружены с момента его открытия. На вопрос, что Meta должна делать с этой проблемой, Шааке ответил: «Не выпускать гаджеты, которые не работают или причиняют вред».

«У меня есть своего рода общедоступный профиль, поэтому это легко доказать и проверить. что я не террорист, вопреки тому, что бот Меты был обучен выплевывать», — сказала она. «Но есть так много людей, о которых деликатные заявления, такие как заявления о тяжких преступлениях, а также противоречивые мнения, когда они живут в условиях репрессий или … предполагаемая сексуальная ориентация может иметь катастрофические последствия».

Шааке обеспокоена тем, что, хотя проблема с BlenderBot может быть относительно легко опровергнута из-за ее профиля, будет много других подобных необоснованных заявлений. ботом, который останется незамеченным.

"Это очевидная ошибка, хотя есть миллиарды решений и результатов, которых мы никогда не увидим, даже если последствия могут быть вредными, а у жертв нет вариантов возмещения ущерба. », — сказала она.

«Компании должны столкнуться с независимым надзором и подотчетностью, и должны быть установлены пороговые значения качества, прежде чем продукты будут выпущены в продажу», — сказала Шааке. «Общество — это не группа людей, над которыми можно экспериментировать, и пользователи Интернета должны спросить себя, прежде чем взаимодействовать с чат-ботами, хотят ли они тратить свое время на помощь Facebook в разработке своего искусственного интеллекта».

Она сказала, что не знает, что делать. что делать с претензией, и следует ли принимать ее дальше с компанией. «Люди предположили, что я могу подать в суд за клевету, — говорит она.

«Было бы интересно посмотреть, как закон защищает от заявлений, сделанных алгоритмами».

Дэниел Середук, специалист по данным Офицер по защите и адвокат из Европы рассказал Daily Dot, что «использование обученного ИИ для создания и публикации алгоритмических выходных данных поднимает интересные юридические вопросы об ответственности создателей ИИ за эти выходные данные».

«Если алгоритмы генерируют результаты, которые были бы незаконными или вредоносными, если бы они были сделаны человеком, безусловно, кто-то мог бы быть привлечен к ответственности, если бы это было сделано с помощью ИИ, будь то оператор ИИ, издатель или, возможно, оба», — сказал он. сказал. «ИИ не может быть оправданием для того, чтобы избежать юридической ответственности только из-за непрозрачности того, как создаются выходные данные, хотя он усложняет доказательство таких вещей, как намерение причинить вред».

Для Тима Тернера, британского эксперта по защите данных, дело готово. «Здесь определенно достаточно, чтобы подать жалобу», — сказал он. «Ваш бот идентифицирует меня как террориста, я не террорист, данные, которые вы обрабатываете, несправедливы и неточны, поэтому я возражаю против использования вами данных обо мне. Это не было бы глупой или беспочвенной жалобой».

Представитель Meta направил Daily Dot сообщение в блоге от 9 августа Джоэль Пино, управляющего директора по фундаментальным исследованиям искусственного интеллекта в Meta, которое было опубликовано. после первоначального шквала проблем с ботом. «Несмотря на то, что некоторые из этих оскорбительных ответов болезненны, публичные демонстрации, подобные этой, важны для создания действительно надежных систем диалогового ИИ и преодоления явного разрыва, который существует сегодня, прежде чем такие системы могут быть запущены в производство», — написал тогда Пино.

Кроме того, они предоставили Daily Dot собственный скриншот похожего разговора, в котором их вопрос побудил BlenderBot ответить: «Нет, Мариетье Шааке не террористка. На самом деле она является одним из членов парламента в [sic] нидерландах».

MetaКогда Daily Dot попыталась воссоздать разговор, чат-бот отказался отвечать.

MetaШааке говорит, что это важно для дополнительной прозрачности со стороны технологического гиганта. «Мета должна объяснять, как работают ее инструменты, и позволять их независимое исследование», — сказала она. «Должен быть надзор».

Узнайте больше о технических и политических материалах Daily Dot